Mise à jour de l’algorithme Google

Accueil > Agence SEO > Encyclopédie SEO > Mise à jour algorithme google

Définition

Depuis sa création en 1998, le moteur de recherche Google indexe et classe des milliards de pages quotidiennement. Sa mission ? Délivrer aux internautes des résultats de recherche qualitatifs, en faisant remonter les sites les plus pertinents par rapport à la requête tapée par l’internaute.

Pour y parvenir, il s’appuie sur un algorithme complexe et secret : la boîte noire de tous les spécialistes SEO.

Cet algorithme est une constellation de multiples sous-algorithmes qui fonctionnent ensemble pour analyser les pages web de la toile. Différents paramètres sont pris en compte dans ce processus délicat. La vitesse de chargement d’une page, l’expérience UX, le nombre de liens entrant ou encore l’utilisation, à bon escient, de mots-clés cohérents sont tous des éléments de classification.

Pour assurer la qualité de ses services, Google effectue des modifications et mises à jour de ses algorithmes. Cela peut affecter le classement des sites web sur la page de résultats de recherche (SERP), et impacter leur référencement SEO. Celles-ci peuvent cependant créer des fluctuations, appelées la Google Dance.

Il est donc essentiel de bien comprendre ce que représentent les algorithmes Google, saisir leur enjeu, afin de pouvoir appréhender les répercussions sur votre site.

Pourquoi Google fait-il des mises à jour de son algorithme ?

L’algorithme de Google, PageRank, a été inventé par Larry Page, le co-fondateur de Google.

Ce système permet de mesurer la popularité d’un site et lui donner un score qui définira ensuite son classement. Avec le temps, d’autres sous-algorithmes ont été injectés dans le système, car certains critères pouvaient être trop facilement manipulés par des experts SEO mal intentionnés.

Dans cette démarche d’amélioration d’expérience utilisateur, Google déclare la guerre aux optimisations et manipulations SEO.

Avec l’aide de ses algorithmes, le géant Américain, a pour objectif de détecter et d’éliminer les contenus “pauvres”. C’est-à-dire créés uniquement dans le but d’obtenir un meilleur positionnement dans la SERP. Plus précisément, les mises à jour (updates) ont pour but de :

- Lutter contre les techniques SEO peu scrupuleuses (Exemple : achat de liens), et les pratiques de spam (Exemple : bourrage de mots-clés).

- Rendre l’expérience utilisateur plus agréable avec des résultats utiles proposés par des sites techniquement solides. (ergonomiques, rapides, sécurisés, responsive, fiables).

- Améliorer la pertinence des résultats en prenant en compte l’intention de recherche des internautes, les nouvelles technologies et les changements de comportement.

- Être à la pointe des dernières tendances sur les attentes des internautes et la diversité des contenus proposés aujourd’hui. (vidéo, image, recherche vocale…)

- Protéger les internautes des contenus rédigés davantage pour les robots Google que pour l’humain, en poussant ceux satisfaisants et originaux et en pénalisant les sites qui ne respectent pas les exigences de Google.

Quel est l’algorithme de Google actuel ?

Comme vu précédemment, l’algorithme Google est composé d’une multitude de sous-algorithmes qui travaillent ensemble afin de scanner, indexer et classer les différentes pages. Volontairement, Google ne nous donne pas sa “recette magique” et il est impossible de savoir précisément de quoi est composé l’algorithme.

Voici toutefois quelques mises à jour majeures en vigueur qui ont été officiellement communiquées :

- March 2024 Core Update : cette mise à jour s’attaque aux contenus de faible qualité et non originaux. Elle pénalise les pages web inutiles, pour améliorer l’expérience utilisateur.

- BERT (Bidirectional Encoder Representations from Transformers) : lancé en 2018, c’est un algorithme spécialiste du traitement automatique de langage naturel (Natural Language Processing ou NLP). Grâce à la technique de l’apprentissage profond” (deep learning), il contribue à l’amélioration de la pertinence des résultats grâce à une meilleure compréhension du sens des requêtes des internautes.

- Rankbrain : lancé en 2015, c’est un système d’IA et d’apprentissage automatique de Google. L’algorithme améliore continuellement sa capacité à comprendre le langage et les intentions derrière les recherches. Il est particulièrement efficace pour interpréter les requêtes ambiguës ou complexes. Il serait devenu le troisième facteur le plus important dans le classement de Google, après le contenu et les liens.

- Navboost : lancé en 2005 et mis à jour depuis. L’algorithme enregistre les données de clics des requêtes pour améliorer la pertinence des résultats. Il fait la différence entre les requêtes faites via un mobile ou ordinateur et prend également en compte la localisation.

Les principales mises à jour de l’algorithme Google

Google évolue en continu et l’amélioration de son algorithme est perpétuelle. Voici les principales mises à jour de l’algorithme au cours des dernières années :

👉 Panda (2011)

L’algorithme a pour objectif de réduire le classement des sites de faible qualité, de contenu pauvre, dupliqué, plagié ou spinné (génération automatique de contenu à l’aide d’un déjà existant). Cela améliore le classement des sites avec un contenu original, utile et de haute qualité.

👉 Penguin (2012)

Cette mise à jour, quant à elle, cible et sanctionne le backlinking de mauvaise qualité. Par exemple, les sites qui ont recours à des réseaux de fermes de liens ou annuaire sont pénalisés. La sur-optimisation des ancres de liens est aussi considérée comme du spam.

👉 Hummingbird (2013)

Refonte complète de l’algorithme principal. Volonté de Google de comprendre les internautes et leurs intentions. Il comprend les requêtes de recherche dans sa globalité en se concentrant sur la recherche sémantique et le contexte des mots-clés.

👉 Pigeon (2014)

Avec cette mise à jour, Google a souhaité apporter plus de pertinence au référencement local. Ainsi, en réponse aux requêtes locales, ciblées géographiquement, les résultats locaux les plus populaires seront mieux positionnés.

👉 Mobilegeddon (2015)

L’algorithme vise à améliorer la vitesse de chargement des pages web sur les appareils mobiles. Cette mise à jour favorise les sites Web responsive, soit optimisés pour les recherches effectuées sur mobiles. L’expérience mobile est un élément primordial lorsque l’on sait que 64 % des recherches sont effectuées sur téléphone mobile.

👉 RankBrain (2015)

Le principal objectif de RankBrain est de comprendre la manière dont les internautes interagissent avec Google. Il s’agit d’appréhender leur comportement de navigation, pourquoi cliquent-ils sur un lien plutôt qu’un autre. C’est également comprendre le sens des requêtes tapées et améliorer la pertinence des résultats de recherche.

👉 Fred (2017)

Cette mise à jour vise les sites qui contiennent beaucoup d’encarts publicitaires. Ils étaient souvent créés simplement pour se positionner en SEO, drainer du trafic et donc générer des revenus grâce aux encarts. Google pénalise ces sites qui privilégient les revenus publicitaires au détriment de l’expérience utilisateur.

👉 BERT (2019)

Basé sur de l’intelligence artificielle et le machine learning, cet algorithme traite le langage naturel et permet de mieux comprendre les types de requêtes complexes.

👉 Core Updates (2017-présent)

Ce sont des mises à jour générales qui visent à améliorer la pertinence globale des résultats de recherche. Ces updates ne ciblent pas particulièrement un type de site ou de contenu, mais cherchent à améliorer l’algorithme de manière générale.

👉 MUM (Multitask Unified Model, (2021)

Basé sur un modèle d’IA avancé pour comprendre les requêtes complexes et les questions de manière plus sophistiquée. MUM combine plusieurs tâches en un seul modèle pour offrir des résultats plus complets. 1000 fois plus puissant que BERT l’algorithme est multilingue (75 langues), multimodal (vidéo, image…) et multitâche (historique de recherche, localisation, etc).

Comment marche l'algorithme de Google ?

Tous les jours, Google doit classer des millions de pages et de sites qui cherchent à se positionner sur les mêmes requêtes. Avec plus de 200 critères de pertinence, l’élaboration de cet algorithme représente une tâche complexe pour les équipes de Google.

Explication générale du fonctionnement de l'algorithme

Pour assurer la qualité des résultats, plusieurs évaluations sont réalisées. L’algorithme est en perpétuelle évolution.

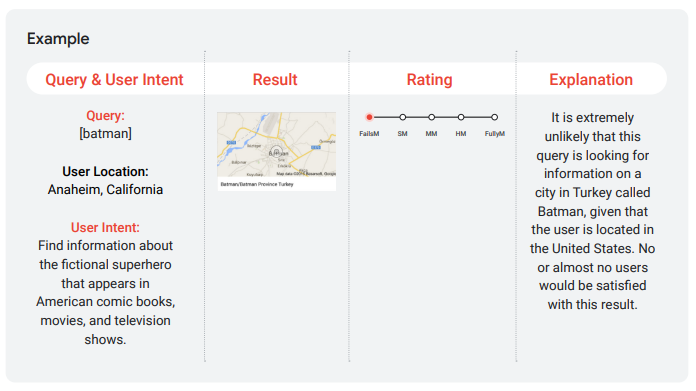

Des évaluations manuelles sont faites ponctuellement et il existe des évaluations effectuées par des “Quality Raters”. Ces derniers sont chargés de vérifier la pertinence des résultats remontés dans la SERP et veillent ainsi à l’efficacité de l’algorithme Google.

Source : Guidelines des Quality Raters

En 2022, on estime que plus de 4725 modifications/ajouts ont été apportés à l’algorithme Google depuis sa création.

Google s’assure également de l’expérience utilisateur en contrôlant que chaque nouveauté introduite dans l’interface est bien appréciée des internautes.

Dans cette guerre déclarée au spam et à la manipulation SEO, l’équipe web spam de Google cherche quotidiennement à détecter les nouvelles tendances et techniques de spamdexing.

Les principaux facteurs de classement

90 % des clics sont effectués sur la première page Google et la première position génère à elle seule plus de 30 % des clics.

Votre classement dans la SERP peut être un véritable “game changer” pour votre activité.

Toutefois, l’art du référencement est un levier complexe. Car vous l’aurez compris, Google et ses algorithmes intelligents se battent pour faire face aux manipulations douteuses du spamdexing.

Néanmoins, voici quelques critères fondamentaux à respecter pour remonter dans l’algorithme Google :

- Un contenu de qualité, pertinent, rédigé pour les internautes et non pour les robots Google.

- Une technique impeccable de votre site (structure hn, vitesse de chargement, mobile friendly…).

- Un maillage interne cohérent et des backlinks de qualité provenant de sites fiables.

- Une bonne expérience UX pour l’internaute avec une mise en page attractive et agréable à lire.

- Des pages bien optimisées selon vos mots-clés, qui répondent à l’intention de recherche de l’internaute (informationnelle, transactionnelle, etc).

Les types de mises à jour de l'algorithme

Il existe différents types de mises à jour de l’algorithme Google selon leur enjeu.

- Les mises à jour majeures sont des changements significatifs qui peuvent avoir un impact significatif sur le positionnement. Souvent annoncées par Google, elles peuvent inclure des modifications dans la façon dont Google évalue et classe les pages Web.

- Les mises à jour mineures, plus fréquentes, peuvent passer inaperçues, car elles ont un impact moindre sur les résultats de recherche. Elles peuvent inclure des ajustements pour corriger des problèmes spécifiques ou améliorer certains aspects de l’algorithme.

- Les mises à jour des filtres sont des ajustements spécifiques aux filtres anti-spam ou aux filtres de qualité, comme Panda ou Penguin, qui ciblent des types spécifiques de contenu ou de pratiques de référencement.

Source : Guidelines des Quality Raters

Quel peut être l’impact d’une mise à jour de l'algorithme ?

L’objectif de Google est d’améliorer les résultats de recherche. Ainsi, toutes les mises à jour effectuées peuvent avoir des conséquences sur le positionnement de votre site.

Comment les mises à jour influencent les stratégies SEO ?

Lorsque vous cherchez à vous positionner dans les résultats Google, vous devez en quelque sorte lui montrer “patte blanche”.

Prouver à Google que vous marchez dans son sens, que vous respectez ses consignes et que votre site est fiable.

Si une nouvelle mise à jour met en avant l’originalité et l’authenticité des contenus et que votre site répond à ce critère, alors votre positionnement sera meilleur. Même chose pour le cas inverse.

Si vous réalisez qu’une mise à jour impacte négativement votre positionnement, alors vous devez effectuer des ajustements et modifications. Vous devrez travailler les nouveaux critères de l’algorithme dans votre site afin de le faire remonter dans les résultats de recherche.

Cela peut impliquer l’amélioration de l’expérience utilisateur, le rafraîchissement de votre contenu, ou encore l’optimisation technique de votre site.

Il est également essentiel de rester informé des dernières mises à jour Google et de contrôler régulièrement les performances de votre site.

Vous pouvez consulter les mises à jour officielles de Google via ce lien.

Adaptation des techniques SEO en réponse aux changements d’algorithme

L’algorithme ne cessera jamais d’être mis à jour. Les référenceurs doivent constamment s’adapter et développer une grande flexibilité face à tous ces changements. Une des clés pour être préparé à ces mises à jour est de focaliser ses efforts sur le EEAT :

- Expérience : information réelle et directe sur le produit ou service (ex: témoignages,avis)

- Expertise : qualité et pertinence des contenus

- Autorité : fraîcheur du contenu et fiabilité

- Trust (confiance) : site sécurisé (https), mentions légales…

Pour contrer l’impact d’une mise à jour Google, vous pouvez commencer par faire le bilan complet de votre site. Identifier les pages et éléments impactés, puis établir par ordre de priorité les zones à traiter.

Soyez également vigilants à l’optimisation de votre contenu. Veillez à sa pertinence, sa mise à jour et son originalité. Faites attention que votre site ne subisse pas d’erreurs de crawl et que Google parvient à lire et indexer toutes vos pages correctement. Par exemple, vérifier que vous n’avez pas de balises robots noindex ou de pages 404.

La vitesse de rapidité de chargement de votre site et son accessibilité sont des facteurs très importants. Enfin, vous devez diversifier la source de vos backlinks et construire un bon maillage interne pour notamment éviter les pages orphelines.

Pour analyser les performances de votre site, n’hésitez pas à utiliser des outils mis à votre disposition tels que : Google Analytics, Google Search Console, Screaming Frog, ou encore Thruuu.

Pourquoi toutes les mises à jour ne sont-elles pas annoncées officiellement ?

Google nous partage officiellement quelques grandes mises à jour et sortie de nouveaux algorithmes. Toutefois, vous vous en doutez bien, il est impossible de savoir exactement tous les éléments composant l’algorithme.

Si nous avions la formule magique, alors tous les référenceurs auraient les clés pour obtenir la position zéro et le classement serait biaisé.

Voilà pourquoi il est important d’être rusé, curieux des nouvelles tendances, informé des annonces Google, d’analyser vos performances et de toujours essayer d’améliorer votre site dans une démarche d’expérience utilisateur. Le SEO est un éternel recommencement.

L’affaire Google leak

En mai 2024, Google a subi une fuite massive des données internes liées à son API de recherche du fonctionnement de l’algorithme.Plus de 2500 modules ont été révélés au grand public.

Ces documents très intéressants nous ont permis de mettre un pied dans la matrice et d’avoir un accès privilégié au vocabulaire interne utilisé par les ingénieurs Google.

- Il en ressortirait que l’autorité d’un site (backlinks reçus), qui était dernièrement niée par Google, est bien un élément primordial pour l’algorithme.

- Les clics sur les résultats de recherche seraient également confirmés être pris en compte, notamment avec Navboost. Google utiliserait aussi les données de navigation comme l’historique et d’autres données personnelles pour améliorer la pertinence des résultats de recherche.

- Il semblerait qu’il existe une liste blanche, composée de sites fiables, qui bénéficieraient d’un traitement préférentiel pour certains types de requête et d’occasion (covid ou période électorale).

- L’existence d’un “sandbox” (bac à sable) qui concerne les nouveaux sites qui seraient mis à l’écart le temps qu’ils soient analysés.

- Les évaluations faites par les quality raters de Google seraient un critère de classement en soi.

Une multitude d’autres éléments ont été dévoilés, notamment concernant les niveaux de classement des backlinks, des ancres, ou encore le nombre de résultats affichés par type de contenu.

Il est important de garder en tête que nous n’avons pas le contexte de ces documents et que nous ne savons pas si ces informations sont toujours d’actualité ou obsolètes.

Néanmoins, cette fuite nous permet de réaliser le niveau de complexité de l’algorithme et de quoi Google est capable pour analyser une page et un site dans son ensemble.

Cette fuite représente un vrai terrain de jeu pour les experts du référencement, et donne beaucoup d’idée de nouveaux tests à mettre en place pour confirmer ou infirmer certaines théories.

Boostez votre visibilité

N’hésitez pas à nous contacter pour obtenir un devis gratuit et personnalisé.