- SEO

Agence SEO

Exploitez le premier levier d’acquisition de trafic en confiant votre référencement à une agence digitale expérimentée en SEO.

- SEA

Agence SEA

Développez rapidement votre business grâce au référencement payant (SEA). - Social Ads

Social ads

Optimisez vos campagnes publicitaires sur les réseaux sociaux pour améliorer vos performances.TikTok adsDevenez viral grâce à vos publicités sur TikTok

- Agence

L'agence

Keyweo est née de l’envie de créer une agence répondant aux principes de transparence, de confiance, d’expérience et de performance.

- Blog

- Contact

Analyse de logs SEO

Accueil > Agence SEO > Encyclopédie SEO > Analyse de logs SEO

Définition

L’analyse des logs (ou des journaux) nous permet de voir les informations que les robots ont obtenu à partir de nos pages lors de leur exploration. Il peut s’agir des dossiers qui ont reçu le plus de requêtes, des codes de réponse du serveur, du type de bot entré, du temps qu’il a fallu pour explorer la page, des types de fichiers qu’ils ont explorés, etc. Pour comprendre pourquoi cela est si important, vous devez savoir que lorsque les robots parcourent le site Web, ils laissent une trace, afin que nous puissions voir leur comportement. L’analyse de cette trace nous permet de savoir comment les robots interagissent avec notre site Web. Lorsque nous extrayons ces informations de nos pages Web, nous devons agir en fonction des résultats que nous obtenons. Dans cet article, vous trouverez toutes les informations nécessaires pour réaliser une analyse de log puissante pour aider votre SEO.

Qu'est-ce qu'un log / journal ?

Les logs (ou journaux) sont des enregistrements (fichiers) qui stockent des informations sur toutes les activités qui se produisent sur un site Web. En d’autres termes, chaque fois qu’un robot ou un utilisateur accède à un site Web, une requête est faite au serveur, et s’il y a une erreur dans le système ou si l’accès a été correct, elle est enregistrée dans un journal.

Sur les serveurs Web, les journaux enregistrent des détails tels que : l’adresse IP, la date et l’heure de la demande, le type de demande, l’URL explorée, le code de réponse et le robot qui a exploré. Ces informations sont utiles, par exemple, pour savoir comment les robots Google explorent une page Web et les éventuels problèmes qu’ils rencontrent.

Les logs vous aident à comprendre ce qui se passe dans le système. Pour le référencement, il est très important de détecter quand ces requêtes ne se passent pas bien. Chaque système peut avoir son propre format de journal, et bien qu’il existe des journaux par défaut, beaucoup préfèrent utiliser le leur.

Nous allons ici expliquer, étape par étape, la meilleure façon d’analyser les logs.

Comment analyser les logs pour le SEO ?

Les logs ne sont pas conservés éternellement, cela dépend de l’hébergeur, donc si vous souhaitez avoir une bonne base de données, vous pouvez les télécharger. Il existe différentes manières d’analyser les journaux de votre site Web, il existe de nombreux outils que vous pouvez utiliser pour analyser ces informations, mais le plus à jour et le plus fiable se trouve sur le serveur sur lequel votre site Web est hébergé.

- Vous devez accéder au panneau de contrôle de votre serveur chez votre hébergeur.

- Cliquez sur l’onglet « Sites Web et domaines »

- Vous devriez trouver l’option « Journaux » ou « Logs »

- Vous avez maintenant votre liste de logs.

Une fois que vous avez vos logs, vous devez savoir quels sont les plus importants que vous devez prendre en compte lorsque vous essayez de les optimiser.

Outils performants pour analyser les logs

Il existe certains outils qui facilitent grandement la présentation et l’interprétation de l’analyse des logs. Ceux recommandés dans cet article sont les plus précis qui existent, le premier d’entre eux étant un outil très puissant qui vient de Google lui-même.

Google Search Console

Cette option est un peu plus directe, on va sur Google Search Console. C’est l’outil Google qui fournit des données sur l’état de votre site Web.

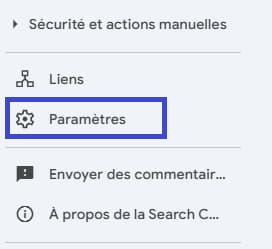

Sur le côté gauche, il y a une colonne de navigation, là vous devez cliquer où se trouve la section Paramètres.

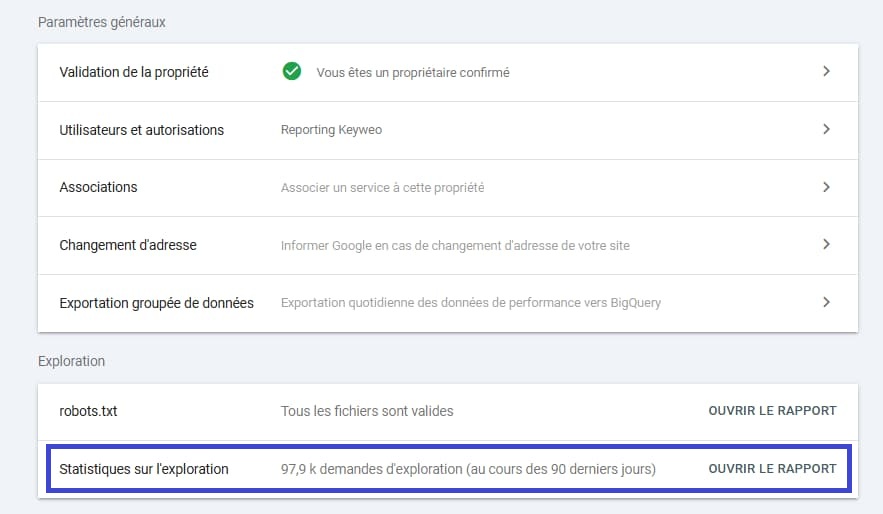

Dans la section « Crawl », nous trouverons des rapports sur le fichier robots.txt et des statistiques de crawl. Dans ce cas, nous ouvrons le rapport Statistiques sur l’exploration.

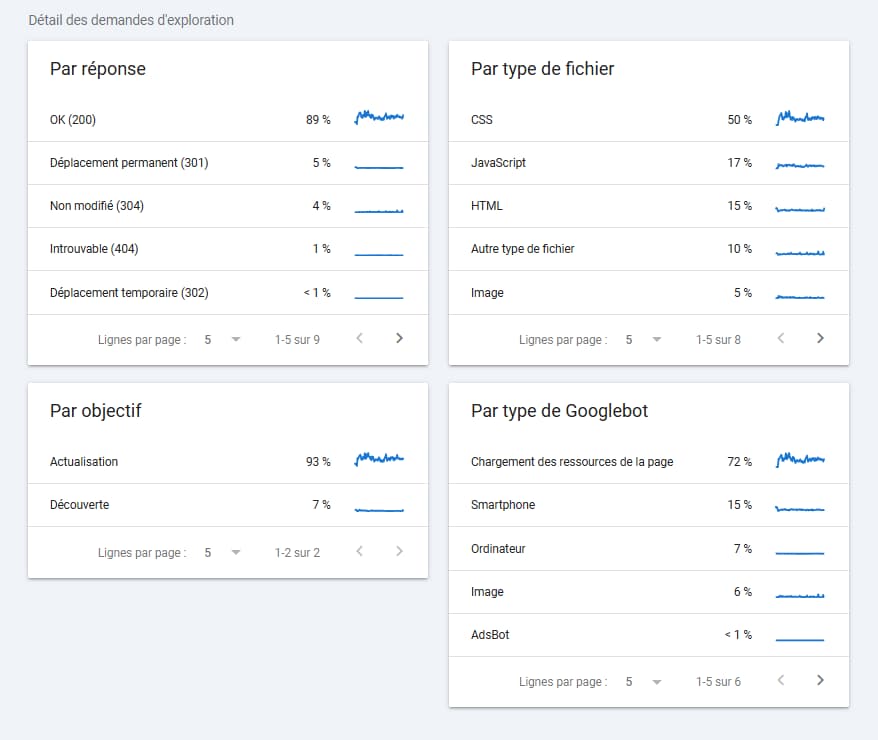

Nous retrouverons les métriques de :

- Nombre total de demandes de suivi.

- Taille totale du téléchargement (Taille de chaque URL).

- Temps de réponse moyen (plus le temps est court, mieux c’est)

Dans la section Hôtes, nous avons les domaines que nous gérons. En cliquant sur l’un d’entre eux, nous obtiendrons le Graphique Général avec les métriques précédentes et les sous-métriques :

- Temps de réponse par code de retour : l’objectif est d’obtenir la quasi-totalité du pourcentage dans le code de réponse 200.

- Types de fichiers de sites Web : indique le type de fichier le plus répandu sur votre site Web. Comme le langage CSS, HTML, Javascript, image ou autres.

- Par objectif : comment les pages ont été détectées, que ce soit par “actualisation” ou par “découverte”. C’est une bonne chose pour le site Web si le robot a trouvé les pages en les mettant à jour..

- Type de robot : Robot mobile/smartphone, robot d’image, robot ordinateur de bureau, robot publicitaire, etc. Ce sont les statistiques à concernant les différents robots que Google a utilisés pour crawler notre site.

Screaming Frog Log Analyzer

Une fois les données téléchargées depuis le serveur, une autre très bonne option pour analyser les logs est de télécharger les fichiers avec Screaming Frog Log Analyzer, c’est un programme différent de Screaming Frog, nous vous laissons un guide détaillé si vous voulez savoir comment l’utiliser. Pour ce faire, nous devons tout d’abord télécharger le programme. Si vous avez la version payante, vous pouvez obtenir plus de données.

- Cliquez sur Projets – Nouveau projet – Donnez un nom.

- Téléchargez le fichier journal téléchargé depuis le serveur.

- En haut des onglets, nous trouverons des filtres sur le type de Bot dont nous voulons obtenir les informations et les dates exactes. Vous pouvez alterner ces filtres pour analyser différents éléments.

Analyser les URL que Google crawle le +

Il doit s’agir de pages qui génèrent du trafic ou qui sont les plus importantes de notre site Web. Il est important d’analyser si ce qui se passe a du sens.

- Dans la section Filtre, sous les onglets, nous filtrerons par HTML pour obtenir des données de Google Bot.

- Dans l’onglet URL, nous pouvons voir toutes les pages qui ont reçu le plus de requêtes.

- Nous allons regarder la colonne N°. des événements, car les URL qui ont plus de requêtes signifient que Google a plus d’affection pour elles. Cela peut être notamment dû aux liens internes et aux liens externes.

Analyser et améliorer l'exploration de Google

- Dans la section Filtre, sous les onglets, nous filtrerons par « Tous » pour obtenir les URL prioritaires dans l’exploration.

- Dans l’onglet URL, nous pouvons encore voir toutes les pages qui ont reçu le plus de hits.

- Nous nous demanderons s’il est judicieux pour Google de donner la priorité à ces pages. Si ce n’est pas le cas, c’est que la page ne fournit pas beaucoup d’informations et de contenu au robot. Une option serait de le bloquer dans robots.txt pour indiquer au bot de ne pas crawler ces pages et, par conséquent, d’améliorer le budget de crawl.

Seolyzer

Seolyzer est un outil puissant pour analyser les logs de votre site Web de manière simple et d’un point de vue purement SEO. Cet outil est payant et possède de nombreuses fonctionnalités intéressantes, même si dans cet article nous nous concentrerons sur les fonctions SEO de base. Voici la procédure étape par étape pour obtenir les informations des robots :

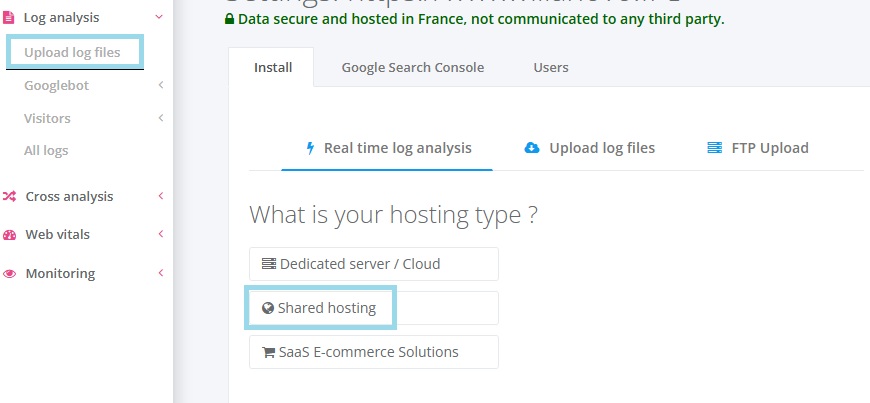

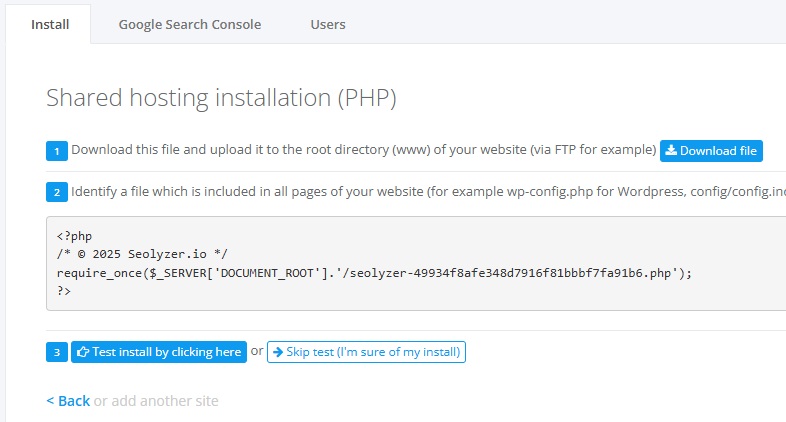

- Une fois que vous vous êtes connectés sur l’outil, vous serez à le paramétrer pour récupérer les données. Selon le type de serveur que vous utilisez, vous devez cliquer sur « Serveur dédié » ou « Hébergement partagé ». Dans ce cas, nous ferons l’exemple avec un « Hébergement partagé ».

- Afin de récupérer toutes les informations, l’outil fournit un code PHP à envoyer à la source de notre site web. Et tout est alors prêt pour que l’outil nous fournisse les données d’enregistrement de notre site Web.

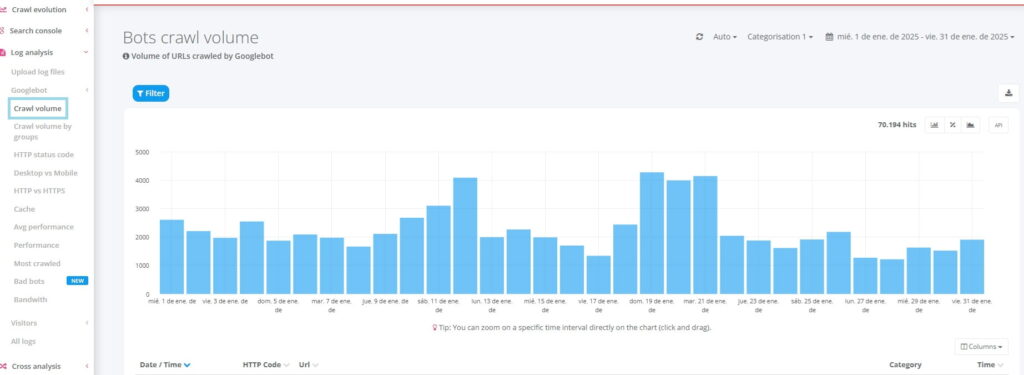

Nous utiliserons la barre latérale pour naviguer et voir ce que Seolyzer a trouvé sur notre domaine. Nous resterons surtout dans la partie analyse des logs – Googlebot. N’oubliez pas qu’en haut à droite, vous pouvez modifier la date pour modifier les informations.

- Volume d’exploration : il s’agit de ce que Googlebot a fait sur notre site Web. En d’autres termes, il s’agit d’un résumé des informations collectées par le bot. Avec le filtrage, vous pouvez ajouter des colonnes et avoir une vue plus globale.

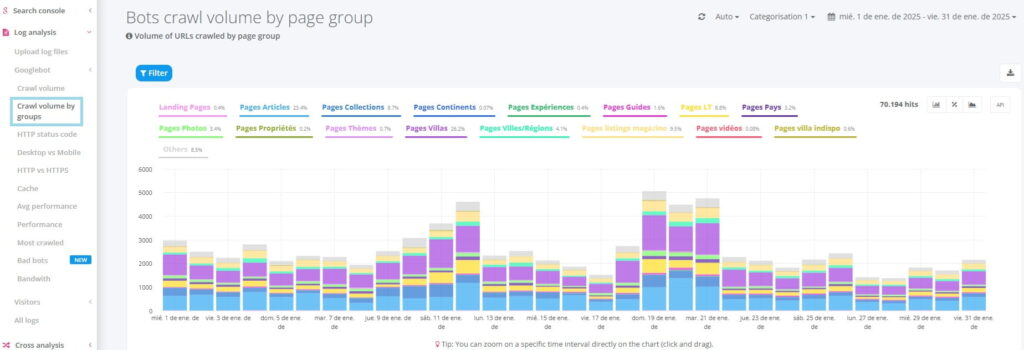

- Volume d’exploration par groupes : nous pouvons créer une segmentation de pages à partir desquels nous souhaitons recevoir des informations. Quelques exemples : regrouper les pages dédiées par cluster ou encore regrouper les pages par type de pages (produits, catégories, blog, etc.).

- Code de réponse : affiche le code de réponse que le bot a obtenu en fonction des demandes qu’il a adressées au serveur. La signification de chaque code est expliquée ci-dessous dans l’article.

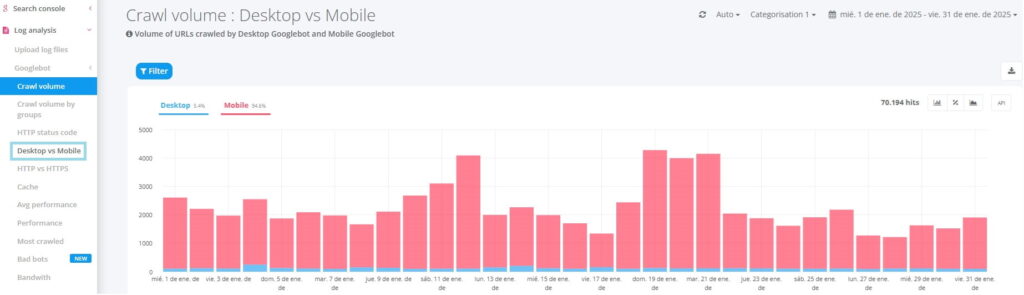

- Mobile vs. Desktop : quel bot visite le plus le site Web, la version mobile ou la version de bureau ? N’oubliez pas que ces dernières années, Google a accordé beaucoup d’importance au robot mobile.

- Pages les plus explorées : l’une des sections les plus importantes. Quelles pages ont reçu le plus de visites de la part du robot ? La colonne « hits » indique le nombre de fois où le site a été exploré par le robot. Ces informations indiquent que le bot est plus intéressé par certaines pages que par d’autres. S’il y a des pages que vous pensez ne pas être importantes pour votre site Web et qui sont très consultées, vous devez prendre des décisions pour améliorer cela.

Informations précieuses des logs pour le référencement

Requêtes avec erreur 50X

Ces erreurs sont de type serveur, ce qui signifie qu’elles n’ont rien à voir avec la façon dont notre site Web est créé. C’est le serveur qui n’a pas fonctionné correctement à ce moment précis et qui renvoie ce code, d’où l’importance de souscrire un bon hébergement. Cela peut également être dû au fait que le serveur est en panne pendant un certain temps, ce qui peut avoir des conséquences négatives sur l’indexation de notre site Web. Dans tous les cas, nous le plus sage est de contacter le développeur Web pour dissiper tout doute et aider dans l’investigation.

Requêtes avec erreur 40X

Il est nécessaire d’identifier les erreurs qui renvoient un code 40X, ce qui signifie que l’URL sur laquelle le bot a navigué n’existe pas. Cela peut être dû au fait qu’une page est en panne, que nous l’avons supprimée ou que vous avez accédé par erreur à une URL inexistante. Pour que le bot évite ce type d’erreur, ces pages doivent être redirigées vers une autre page qui lui est liée.

Si une URL avec ce code obtient des liens, qu’ils soient internes ou externes, ils doivent être corrigés pour pointer vers la nouvelle URL.

Requêtes avec redirections 301

Avoir des pages avec des redirections 301 est normal, ne vous inquiétez pas. Ces pages avec redirections aident à éviter les erreurs de navigation, même si vous devez avoir un bon contrôle sur les pages qui ont ce code. Il est important de noter que les pages avec 301 ne devraient pas obtenir de liens internes ou externes car leur fonction est de servir de pont entre 2 pages. Les liens pointant vers ces URL doivent pointer vers l’URL finale.

Nombre de requêtes par dossier

Ces informations nous indiquent quels dossiers de notre architecture reçoivent le plus de hits. En d’autres termes, il nous indique les pages les plus importantes ou les plus pertinentes pour les robots.

Il faut prendre en compte que plus il y a d’URL à l’intérieur d’un dossier, plus il est logique qu’il reçoive beaucoup de requêtes, il est donc important de comprendre le ratio de requêtes pour comprendre la pertinence.

Temps et fréquence d'exploration d'un robot

Grâce à l’analyse de logs pour le SEO, nous pouvons observer quelles pages sont rarement visitées ou explorées ou au contraire, beaucoup trop. La stratégie consiste à développer une méthode de navigation afin que les robots puissent accéder plus facilement à ces pages. Avoir des liens internes dans l’architecture interne améliore considérablement l’exploration de ces pages.

Si une URL ne contient pas de tels liens, il n’existe aucun moyen simple d’explorer la page, elle risque de ne pas être indexée et n’apparaîtra pas dans les résultats.

Le pire des cas est l’existence de pages orphelines, qui sont des pages qui ne reçoivent pas de liens et qui ne sont pas accessibles depuis l’architecture du site. Moins nous avons de pages de ce type, mieux c’est pour notre site Web.

Ces 5 éléments sont ceux qui ont le plus grand impact SEO si les statistiques s’améliorent. Ce n’est pas une tâche facile, mais leur importance est vitale pour votre site Web.

Quand est-il nécessaire d’effectuer une analyse des logs ?

Il n’est pas toujours nécessaire de faire de l’analyse de logs, mais à un moment donné, nous devons consacrer du temps, mais dans certaines situations, cela devient indispensable. De plus, c’est un moyen de soigner notre site Web au cas où il aurait des problèmes comme ceux que nous avons vus ci-dessus.

Vous avez apporté des modifications à l'architecture SEO de votre site Web

Lorsque nous travaillons à améliorer le positionnement organique de notre site Web, il est souvent nécessaire d’apporter des modifications à l’architecture, c’est-à-dire à la façon dont les pages sont organisées et à la façon dont elles se connectent les unes aux autres à l’intérieur d’un site. Cela peut inclure la réorganisation du menu, la mise à jour des liens internes ou même la modification de certaines URLs. Après avoir effectué ces modifications, il est très important de s’assurer que les robots des moteurs de recherche explorent correctement les nouvelles URLs qui ont été modifiées.

Si vous ne pouvez pas accéder à ces URLs, elles risquent de ne pas être indexées et cela affecterait négativement le trafic et le positionnement.

Vous avez un très grand site Web

Il est important de faire de manière récurrente de l’analyse de logs SEO, notamment lorsque le site Web sur lequel nous travaillons a de nombreuses URLs, plusieurs dizaines de milliers, des centaines de milliers, voire des millions. Cela se produit généralement sur des sites Web dédiés à l’actualité et au commerce électronique avec de nombreux produits.

Vous avez des problèmes avec l'indexation des pages

Si vous rencontrez des problèmes d’indexation pour que vos pages apparaissent dans les résultats de recherche, il est judicieux d’analyser vos logs d’accès. Cela permettra de savoir à quelles URL les robots des moteurs de recherche accèdent. De cette façon, nous pouvons vérifier s’ils visitent les URLs que nous souhaitons indexer. Il est important de vérifier d’abord que la page possède la balise robots avec la valeur « index », qu’elle ne soit pas bloquée par des robots et également que la page renvoie un code 200 (indiquant que la page est disponible).

Les robots les plus courants qui explorent notre site Web

Le moteur de recherche le plus important au monde, Google, en possède plusieurs, chacun ayant une tâche spécifique qui aidera à mieux comprendre le contenu de notre site Web et de quoi il s’agit. Voici les plus importants :

- Googlebot: Il est chargé de rechercher et d’explorer nos pages Web afin qu’elles puissent ensuite être indexées.

- Google adsbot: Il est en charge de la partie publicitaire. Il est responsable des campagnes créées dans Google Ads et est chargé de visiter les pages de destination créées spécifiquement pour ces campagnes.

- Google Images: Suit toutes les informations sur les images de la page. Toute optimisation dans les images sera d’une grande importance pour lui.

- Google News: La section actualités est sa spécialité, toutes les nouvelles entrées et nouvelles informations seront suivies par elle.

- Google videos: L’intégration de vidéos peut être pertinente pour certains contenus, c’est pourquoi Google dispose d’un BOT spécifique pour cette pratique.

- Google adsense: La publicité est un moyen de monétiser vos pages. Il est chargé de suivre toutes les publicités affichées sur les sites Web et de les contrôler.

- Google mobile: Uno de los más importantes en los últimos años, debido a que los usuarios cada vez realizan más búsquedas en móvil que en ordenador. Se encarga de rastrear la web con el formato móvil para indexarla.

D’autres robots parcourent également notre site Web de temps à autre, en faisant des demandes au serveur pour y accéder. Nous ne recevrons pas toujours des demandes de robots bien intentionnés qui souhaitent simplement explorer notre site Web.

Il y a des cas où les demandes sont faites trop fréquemment, ce qui peut ralentir et empêcher les autres de crawler le site sans problème. Dans ces cas-là, nous pourrons essayer de les contrôler grâce au fichier robots.txt ou, plus radical, au fichier .htaccess.

Conclusion

Vous savez maintenant ce qu’est une analyse de log et son importance dans le monde du référencement. Cette pratique puissante vous aidera à optimiser l’exploration des moteurs de recherche, à identifier et à résoudre les problèmes techniques les + avancés et à améliorer la visibilité d’un site Web dans les résultats de recherche.

Questions fréquemment posées

Analyser les données stockées sur un serveur de site Web, sous la forme de fichiers journaux de l'interaction entre un serveur et un robot qui a exploré le Web.

Dans cet article, nous expliquons ce qu'est l'analyse de logs et comment vous pouvez facilement les analyser.

Télécharger les journaux de votre serveur et essayer de les comprendre n'est pas une tâche facile. C'est pourquoi dans cet article nous vous recommandons une série d'outils avec lesquels vous pourrez effectuer votre analyse de logs sans complications.

- N'oubliez pas de bien collecter les données.

- Analysez-les avec un outil recommandé pour obtenir des insights.

- Surveiller et configurer l'outil.

Il existe de nombreux outils que vous pouvez utiliser pour analyser les journaux du serveur et le robot qui a exploré votre site.

Nous recommandons 3 outils que nous considérons comme les meilleurs pour comprendre les informations dans les logs :

- Google Search Console

- Analyseur de logs de Screaming Frog

- Seolyzer

Les définitions les plus populaires

page alias

page amp google

page gateway

page orpheline

page passerelle

page satellite

page zombie

pagination en seo

pied de page

header

sitemap

Boostez votre visibilité

N’hésitez pas à nous contacter pour obtenir un devis gratuit et personnalisé.

Notez ce page