- SEO

Agence SEO

Exploitez le premier levier d’acquisition de trafic en confiant votre référencement à une agence digitale expérimentée en SEO.

- SEA

Agence SEA

Développez rapidement votre business grâce au référencement payant (SEA). - Social Ads

Social ads

Optimisez vos campagnes publicitaires sur les réseaux sociaux pour améliorer vos performances.TikTok adsDevenez viral grâce à vos publicités sur TikTok

- Agence

L'agence

Keyweo est née de l’envie de créer une agence répondant aux principes de transparence, de confiance, d’expérience et de performance.

- Blog

- Contact

Google BERT

Accueil > Agence SEO > Encyclopédie SEO > Google BERT

Définition

Google BERT est une mise à jour algorithme Google apportée en 2019 dans son moteur de recherche. BERT vient de l’acronyme “Bidirectionnel Encoder Representations from Transformers”. C’est un modèle du traitement de langage NLP (Natural Language Processing). Basé sur l’intelligence artificielle, ce système permet de mieux comprendre la langue utilisée par les utilisateurs dans leurs recherches. BERT vise à optimiser la pertinence des résultats présentés sur les SERP (les pages de résultats de recherche) en utilisant le deep learning pour mieux saisir le sens exact des demandes des utilisateurs en ligne.

Accès rapide

BERT permet de comprendre le contexte bidirectionnel du langage, contrairement à des modèles précédents employant une approche undirectionnelle pour traiter le texte. Cela signifie qu’une phrase est analysée en deux directions, en prenant en compte le contexte linguistique des mots pour en déduire le sens. Cette approche lui donne la capacité de saisir plus précisément les nuances du langage humain. BERT est capable de déterminer la cohérence sémantique d’une phrase.

Quels sont les avantages de BERT ?

BERT présente de nombreux avantages. Parmi ceux-ci, un des plus importants est sa capacité de comprendre les intentions de recherche des utilisateurs pour améliorer la pertinence des résultats de recherche. De la classification de texte à la traduction automatique, le modèle convient à diverses tâches liées au traitement du texte. BERT a la capacité d’identifier le ton et les sentiments exprimés dans un texte en examinant son contenu.

De plus, BERT identifie les nuances et les subtilités du langage naturel, en comprenant le sens des mots en fonction du contexte. Il ne va pas simplement lire un mot et proposer des résultats liés à celui-ci mais prendre le texte global pour répondre aux demandes des utilisateurs. Par ailleurs, il permet de proposer des réponses plus pertinentes et précises aux questions des utilisateurs. Il est également capable de rectifier la grammaire d’un texte, en saisissant le contexte des phrases et en suggérant des ajustements appropriés.

Comment fonctionne Google BERT ?

L’algorithme BERT se base sur le deep learning, une discipline de l’intelligence artificielle qui forme des réseaux neuronaux artificiels sur d’énormes volumes de données. Grâce à son réseau neuronal Transformer, basé sur l’attention, il peut saisir les liens entre les mots présents dans une phrase. En effet, deux mécanismes distincts constituent un Transformer : un encodeur et un décodeur. Le premier lit l’entrée, le second génère la prévision de la tâche. L’approche bidirectionnelle permet à Google BERT de comprendre en profondeur le contexte d’une phrase recherchée par un utilisateur sur Google, en analysant les mots situés de part et d’autre d’un mot-clé (ceux qui le précèdent et le suivent).

Ainsi, les algorithmes Google sélectionnent les contenus répondant le mieux à la recherche d’un utilisateur pour permettre à celui-ci des résultats des SERP davantage pertinents. Google BERT va donc se charger d’indiquer aux algorithmes ce que les utilisateurs doivent exactement trouver. Cependant, il est important de noter que bien que Google BERT impacte davantage les requêtes de longue traîne (plusieurs mots), cela ne veut pas dire pour autant qu’elles seront toutes impactées par cet algorithme. Cela est lié à la complexité et aux multiples intentions potentielles, et les requêtes conversationnelles sont les plus concernées.

Exemples

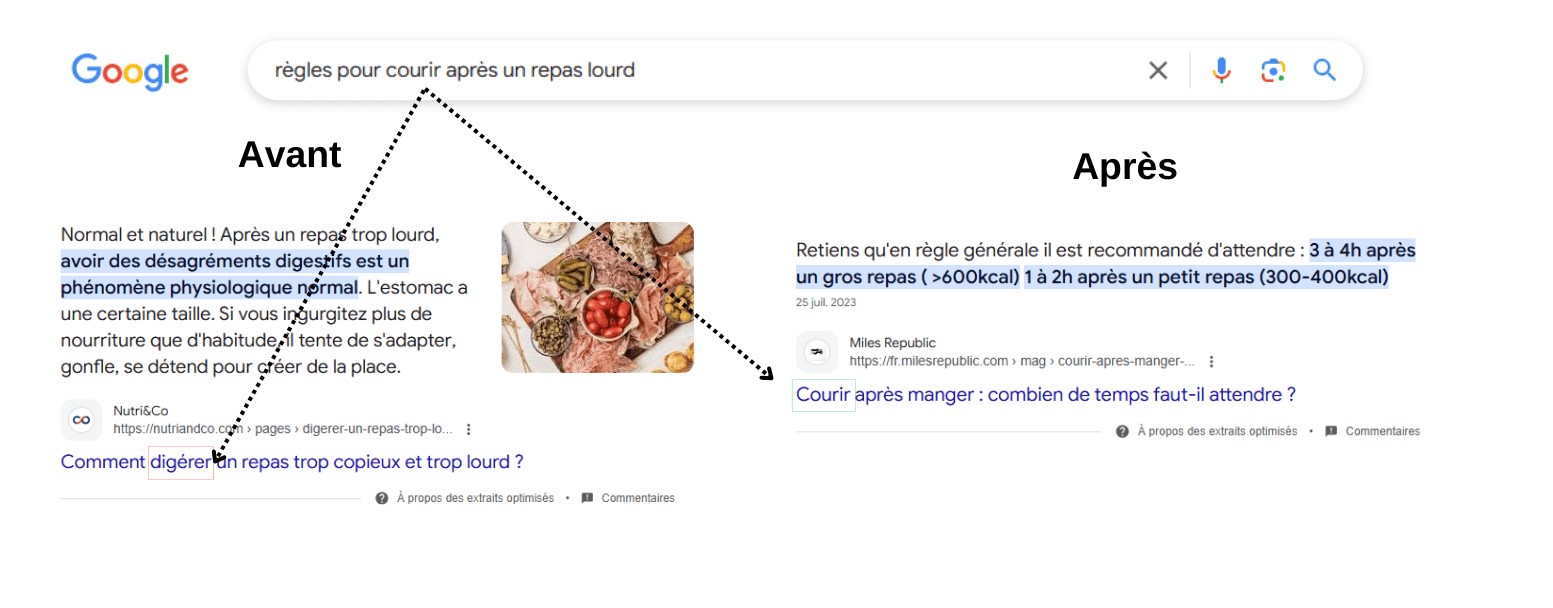

Pour mieux comprendre comment fonctionne Google BERT, prenons un exemple pour un cas spécifique concernant la demande “règles pour courir après un repas lourd”. L’algorithme précédent aurait tout simplement traité cette requête en n’utilisant que les termes “courir”, “règles”, “repas lourd”. Les résultats auraient ainsi pu inclure des articles sur la digestion après un repas lourd, des guides pour courir sans faire de lien entre le sport et le repas, ou encore des règles générales sur la course.

Cette fois-ci, c’est l’algorithme BERT qui privilégiera le terme “après un repas lourd” pour produire une multitude d’interprétations découlant de son association avec d’autres mots, offrant par conséquent des réponses plus précises. Il va ainsi comprendre que, dans la recherche, on veut des recommendations sur la pratique de la course après un lourd repas, et les résultats seront donc en accordance avec cette demande. Les articles proposés sont donc davantage axés sur les effets d’un repas copieux sur la performance physique, les risques digestifs liés à l’exercice après un repas lourd ou des conseils de temps d’attente recommandé avant de courir.

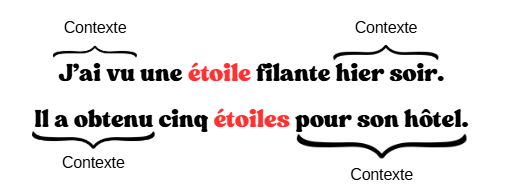

De plus, il est crucial d’avoir un modèle bidirectionnel pour saisir réellement le sens d’un langage. Observons un exemple pour mettre en évidence cela. Dans cette illustration, on retrouve deux phrases qui incluent le terme “étoile”.

Il faut faire attention au sens du terme “étoile” dans ces deux exemples. En effet, en lisant le contexte, on comprend qu’il ne s’agit pas du même type d’étoile, l’un faisant référence à une étoile filante tandis que l’autre évoque l’obtention d’un grade pour un hôtel. Ainsi, se baser exclusivement sur le contexte gauche ou droit est une mauvaise stratégie qui induit en erreur pour comprendre le sens du mot “étoile”. La bonne méthode pour gérer ce problème consiste à considérer simultanément le contexte gauche et le contexte droit avant de procéder à une prédiction. L’outil BERT accomplit exactement cette tâche.

Les différences avec d’autres outils Google

Google Gemini (anciennement BARD)

Google BERT et Google BARD sont deux outils puissants générés par Google pour comprendre les langues de différentes manières. Google BARD (Biological Application Resource Discovery) était un chatbot permettant aux utilisateurs de poser leurs questions et un robot répond à leurs demandes, d’une manière humaine, au travers de conversations ouvertes. Depuis début 2023, il a été remplacé par Gemini, avec des fonctionnalités ressemblant à celles de ChatGPT. Cet assistant IA permet notamment de répondre à des requêtes textuelles, générer des images ou encore proposer différents types de réponses.

Ce qui différencie principalement les deux outils est la manière dont ils sont désignés pour comprendre les langages. Gemini va être utilisé pour avoir des conversations avec les utilisateurs tandis que BERT sert à comprendre le sens des mots et phrases. Une autre différence est le type de données. En effet, Gemini emploie des données labélées spécifiquement pour des conversations alors que BERT emploie de vastes données non labellées.

RankBrain

RankBrain, lancé par Google en 2015, est un algorithme de moteur de recherche basé sur l’apprentissage automatique. Tout comme BERT, son objectif était d’améliorer l’intention de recherche des utilisateurs et fournir des résultats plus utiles. RankBrain examine les demandes des utilisateurs afin de saisir le lien entre les mots et le contexte.

BERT, qui est une mise à jour de RankBrain, enrichit et complète le processus de RankBrain, mais ne le substitue pas totalement. Google est libre de choisir la manière d’interpréter une demande particulière et d’utiliser une ou plusieurs méthodes, ou parfois un mélange des deux.

Optimiser ses contenus SEO avec BERT

Répondre aux intentions de recherche

Afin d’optimiser le contenu pour BERT, il est crucial de produire un contenu de qualité supérieure et d’apporter des réponses précises aux interrogations des usagers. Effectivement, pour répondre à celles-ci, il est nécessaire de proposer des réponses détaillées et complètes qui détaillent en profondeur les thématiques traitées. On peut atteindre cet objectif en présentant des exemples tangibles, des cas d’étude, des comparaisons et des statistiques, pour ne mentionner que quelques exemples.

Utiliser un langage naturel et une bonne structure

Il est important d’utiliser un langage naturel et de structurer le contenu de manière claire et logique. Il faut que le contenu soit facile à lire, avec des phrases courtes et simples. Il est tout aussi crucial d’offrir aux lecteurs une vue d’ensemble précise des attentes à propos de l’article ou de la page, en employant des titres, sous-titres et paragraphes pour structurer le contenu.

Recherche vocale

Google cherchant à utiliser le même type de langage que ses utilisateurs, c’est à dire un langage naturel, conversationnel et fluide, s’adapter aux nouvelles pratiques de recherches vocales est une bonne stratégie à adopter. Cela implique l’emploi de tournures de phrases spontanées, la production de contenu qualitatif et utile, et l’apport de réponses précises et claires qui peuvent être dictées par des assistants vocaux.

Le recours aux prépositions et aux articles

Les prépositions et des articles comme “pour”, “du”, “comme”, “à”… n’étaient pas prises en compte par Google auparavant. En effet, ce qu’on désigne sous le terme de mots vides (ou stop words) étaient jugés comme inutiles à indexer et à comprendre par le moteur de recherche : ils avaient une signification sémantique trop faible. En général, ces mots ne présentent aucun intérêt pour l’interprétation d’une intention par Google. Cependant, sur des demandes plus significatives et plus subtiles, ils ont une importance primordiale.

BERT intervient ainsi en proposant une avancée majeure : les mots des requêtes sont coimpris les uns par rapport aux autres. Ainsi, ces stop words peuvent être employés dans un contenu lorsque cela est approprié et nécessaire : ils ne constituent plus une perte de temps.

Les changements dans la pratique SEO

L’instauration de la mise à jour Google BERT représente une évolution majeure pour Google, en essayant toujours de mieux comprendre le sens des mots. Cet algorithme permet d’interpréter le contenu des pages web d’une manière plus intelligente, considérant la totalité du lexique plutôt qu’en se concentrant uniquement sur des mots-clés précis. Lors de son lancement, BERT concernait uniquement les requêtes en anglais, mais s’est progressivement déployé pour la France et 70 autres pays.

Google BERT se focalise sur des demandes particulièrement spécifiques, qu’elles soient « complexes » ou « orales », et fréquemment les deux. Cela concerne les demandes qui comportent plus de quatre ou cinq mots. Ces dernières constituent environ 10 % de toutes les demandes effectuées sur le moteur de recherche. Cependant, il n’y a pas de différence dans le traitement des pages pour ceux qui pratiquent déjà un référencement naturel de qualité, puisque la compréhension des requêtes longues existait déjà au préalable. Pour rappel, Google BERT est une évolution de la stratégie de Google en matière de compréhension du langage naturel et des intentions des internautes.

Les définitions les plus populaires

seo

seo amazon

seo camp

seo e-commerce

seo freelance

seo friendly

seo international

seo local

seo multilingue

seo off page

seo on page

seo technique

seo vocal

seo youtube

Boostez votre visibilité

N’hésitez pas à nous contacter pour obtenir un devis gratuit et personnalisé.

Notez ce page